Alla GTC, Nvidia non ha fatto mancare la propria presenza, mandando live un evento proprio, nel quale sono stati fatti molti annunci, tra i quali CPU, GPU e nuove infrastrutture per Data Center.

GPU per Data Center e professionali

L’evento GTC si è aperto con il CEO Nvidia Jensen Huang che ha parlato ampiamente dell’importanza dell’IA in ogni ambito del mondo moderno, spaziando dai Supercomputer, all’IA per i Data Scientist, fino ad arrivare all’automotive.

Poco dopo Jensen ha annunciato il lancio di nuove schede dedicate al settore dei Data Center e schede desktop per i professionisti.

Le prime schede presentate sono state le nuove RTX A4000 ed A5000, basate rispettivamente sulle GPU GA104 (RTX 3070) e GA102 (RTX 3080).

Le nuove schede portano con sè tutte le innovazioni dell’architettura Ampere. Esse infatti dovrebbero garantire, a detta di Nvidia, fino al doppio delle performance in Real Time Rendering e grossi passi in avanti riguardo l’efficienza degli RT Cores e Tensor Cores.

Le due schede presentano il supporto al NVLink, quindi permettendo agli utenti di creare sistemi multi-GPU. La principale differenza tra le due GPU è data dal differente numero di CUDA Cores e di VRAM. Sono di fatto 6144 CUDA nella RTX A4000, affiancati da 16 GB di GDDR6 su un Bus a 256-bit. Mentre la RTX A5000 ne presenta ben 8192, affiancati da 24 GB di GDDR6 su un Bus a 384-bit.

Per i professionisti in mobilità che necessitano di dispositivi sottili e leggeri, sono state annunciate delle nuove GPU per laptop. Le schede in questione sono le NVIDIA RTX A2000, NVIDIA RTX A3000, RTX A4000 e RTX A5000. Queste schede dovrebbero offrire prestazioni accelerate senza compromettere la mobilità, essendo queste proposte esclusivamente come varianti MAX-Q.

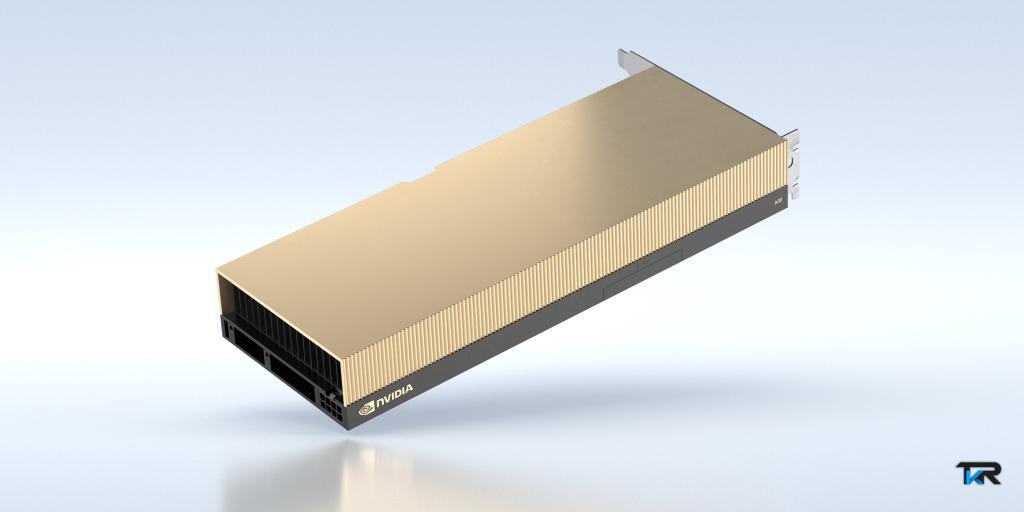

Per i Data Center sono state annunciate le Workstation A10 e A16, dedicate per utenti quali designers ed ingegneri. L’A10 garantisce fino a 2,5 volte le prestazioni da workstation virtuale della generazione precedente. Mentre la GPU A16 offre una densità utente fino a 2 volte superiore ed un costo totale di proprietà inferiore, migliorando al contempo l’esperienza desktop virtuale rispetto alla generazione precedente.

Le schede per Desktop e Data Center saranno rese disponibili presso i vari OEM entro la fine del mese, mentre per le varianti laptop bisognerà attendere almeno fino all’estate 2021.

CPU ARM-based per Automotive e Data Center

Nella giornata di ieri Nvidia ha presentato qualcosa che nel prossimo futuro potrebbe essere veramente importante, dato che la società ha deciso di entrare nel mercato CPU.

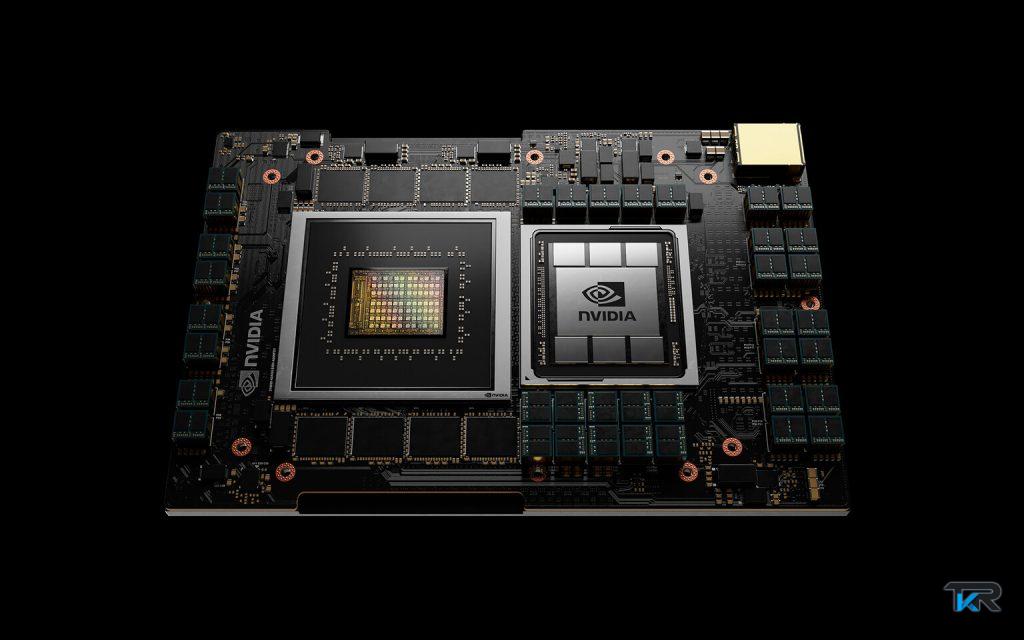

La CPU targata Nvidia è basata su architettura ARM ed è denominata Grace, nome preso dalla scienziata Grace Hopper. La CPU in questione è stata progettata per potersi assicurare un maggior livello di performance nei carichi IA.

Tali CPU infatti, permettono di ottenere delle performance 10 volte superiori (in carichi GPU bound) rispetto alle più convenzionali CPU x86.

Il chip sarà reso disponibile a partire dal 2023 e le prime specifiche tecniche parlano di caratteristiche di connettività e Bandwidth fuoriscala. Si parla infatti di ben 500 GB di Bandwidth per le RAM ECC, 900 GBps per l’interconnessione NVLink tra CPU-GPU e 600 GBps per quella CPU-CPU.

E’ stato inoltre già annunciato che i primi due clienti ad usufruire delle nuove CPU ARM di Nvidia saranno il CSCS (Centro Svizzero di Calcolo Scientifico) e il LANL (Los Alamos National Laboratory).

Il sistema del CSCS sarà chiamato Alps ed il quale dovrebbe raggiungere la potenza di 20 ExaFLOPs per operazioni di calcolo IA, rappresentando il più potente Data Center al mondo dedicato al Machine Learning.

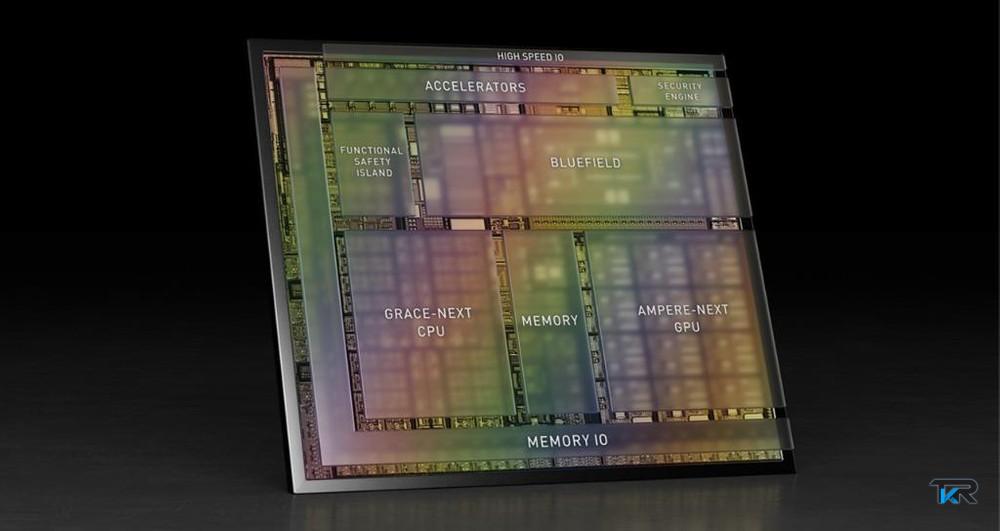

Sono state annunciate anche dei SoC dedicate al settore Automotive, le quali avranno come nome in codice Atlan e non arriveranno prima del 2025.

I dettagli sono limitati, ma quello che si sà è che la GPU è rappresentata da una GPU di prossima generazione, indicata da Nvidia come Ampere-Next, mentre la CPU sarà basata su un processore Grace. Nel Chip sarà inoltre DPU (Data Processing Unit) con nome in codice BlueField che permetterà di gestire più efficacemente i carichi IA per la guida autonoma.